Tensorflow एक मशीन लर्निंग फ्रेमवर्क है जो Google द्वारा प्रदान किया जाता है। यह एक ओपन-सोर्स फ्रेमवर्क है जिसका उपयोग पायथन के संयोजन में एल्गोरिदम, गहन शिक्षण अनुप्रयोगों और बहुत कुछ को लागू करने के लिए किया जाता है। इसका उपयोग अनुसंधान और उत्पादन उद्देश्यों के लिए किया जाता है। इसमें अनुकूलन तकनीकें हैं जो जटिल गणितीय कार्यों को शीघ्रता से करने में मदद करती हैं। ऐसा इसलिए है क्योंकि यह NumPy और बहु-आयामी सरणियों का उपयोग करता है। इन बहु-आयामी सरणियों को 'टेंसर' के रूप में भी जाना जाता है। फ्रेमवर्क गहरे तंत्रिका नेटवर्क के साथ काम करने का समर्थन करता है

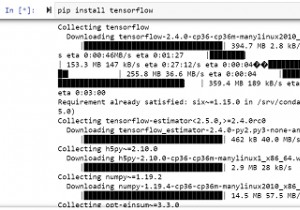

कोड की निम्न पंक्ति का उपयोग करके विंडोज़ पर 'टेंसरफ़्लो' पैकेज स्थापित किया जा सकता है -

pip install tensorflow

Tensor एक डेटा संरचना है जिसका उपयोग TensorFlow में किया जाता है। यह प्रवाह आरेख में किनारों को जोड़ने में मदद करता है। इस प्रवाह आरेख को 'डेटा प्रवाह ग्राफ' के रूप में जाना जाता है। टेंसर और कुछ नहीं बल्कि एक बहुआयामी सरणी या एक सूची है।

हम इलियड के डेटासेट का उपयोग करेंगे, जिसमें विलियम काउपर, एडवर्ड (डर्बी के अर्ल) और सैमुअल बटलर के तीन अनुवाद कार्यों का टेक्स्ट डेटा शामिल है। जब पाठ की एक पंक्ति दी जाती है तो मॉडल को अनुवादक की पहचान करने के लिए प्रशिक्षित किया जाता है। उपयोग की गई टेक्स्ट फ़ाइलें प्रीप्रोसेसिंग कर रही हैं। इसमें दस्तावेज़ शीर्षलेख और पाद लेख, पंक्ति संख्या और अध्याय शीर्षक निकालना शामिल है।

हम नीचे दिए गए कोड को चलाने के लिए Google सहयोग का उपयोग कर रहे हैं। Google Colab या Colaboratory ब्राउज़र पर पायथन कोड चलाने में मदद करता है और इसके लिए शून्य कॉन्फ़िगरेशन और GPU (ग्राफ़िकल प्रोसेसिंग यूनिट) तक मुफ्त पहुंच की आवश्यकता होती है। जुपिटर नोटबुक के ऊपर कोलैबोरेटरी बनाई गई है।

उदाहरण

निम्नलिखित कोड स्निपेट है -

vocab_size += 2

print("Configure the dataset for better performance")

train_data = configure_dataset(train_data)

validation_data = configure_dataset(validation_data)

print("Train the model")

model = create_model(vocab_size=vocab_size, num_labels=3)

model.compile(

optimizer='adam',

loss=losses.SparseCategoricalCrossentropy(from_logits=True),

metrics=['accuracy'])

print("Fit the training data to the model")

history = model.fit(train_data, validation_data=validation_data, epochs=3)

print("Finding the accuracy and loss associated with training")

loss, accuracy = model.evaluate(validation_data)

print("The loss is : ", loss)

print("The accuracy is : {:2.2%}".format(accuracy)) कोड क्रेडिट - https://www.tensorflow.org/tutorials/load_data/text

आउटपुट

Configure the dataset for better performance Train the model Fit the training data to the model Epoch 1/3 697/697 [==============================] - 35s 17ms/step - loss: 0.6891 - accuracy: 0.6736 - val_loss: 0.3718 - val_accuracy: 0.8404 Epoch 2/3 697/697 [==============================] - 8s 11ms/step - loss: 0.3149 - accuracy: 0.8713 - val_loss: 0.3621 - val_accuracy: 0.8422 Epoch 3/3 697/697 [==============================] - 8s 11ms/step - loss: 0.2165 - accuracy: 0.9162 - val_loss: 0.4002 - val_accuracy: 0.8404 Finding the accuracy and loss associated with training 79/79 [==============================] - 1s 2ms/step - loss: 0.4002 - accuracy: 0.8404 The loss is : 0.40021833777427673 The accuracy is : 84.04%

स्पष्टीकरण

-

मॉडल को पूर्व-संसाधित, वेक्टरकृत डेटासेट पर प्रशिक्षित किया जाता है।

-

एक बार यह हो जाने के बाद, इसे संकलित किया जाता है और मॉडल में फिट किया जाता है।

-

मॉडल से जुड़े नुकसान और सटीकता का मूल्यांकन 'मूल्यांकन' पद्धति का उपयोग करके किया जाता है।

-

यह डेटा कंसोल पर प्रदर्शित होता है।