'व्हाइटस्पेसटोकनाइज़र' को कॉल करके टेन्सरफ़्लो टेक्स्ट का उपयोग व्हाइटस्पेस टोकनाइज़र के साथ किया जा सकता है, जो एक टोकनेज़र बनाता है, जिसका उपयोग स्ट्रिंग पर 'टोकनाइज़' विधि के साथ किया जाता है।

और पढ़ें: TensorFlow क्या है और Keras कैसे तंत्रिका नेटवर्क बनाने के लिए TensorFlow के साथ काम करता है?

हम केरस अनुक्रमिक एपीआई का उपयोग करेंगे, जो एक अनुक्रमिक मॉडल बनाने में सहायक है जिसका उपयोग परतों के एक सादे ढेर के साथ काम करने के लिए किया जाता है, जहां हर परत में एक इनपुट टेंसर और एक आउटपुट टेंसर होता है।

एक तंत्रिका नेटवर्क जिसमें कम से कम एक परत होती है, एक दृढ़ परत के रूप में जानी जाती है। हम लर्निंग मॉडल बनाने के लिए कन्वेन्शनल न्यूरल नेटवर्क का उपयोग कर सकते हैं।

TensorFlow Text में टेक्स्ट से संबंधित क्लासेस और ऑप्स का संग्रह होता है जिसका उपयोग TensorFlow 2.0 के साथ किया जा सकता है। TensorFlow टेक्स्ट का उपयोग अनुक्रम मॉडलिंग को प्रीप्रोसेस करने के लिए किया जा सकता है।

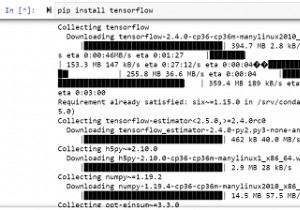

हम नीचे दिए गए कोड को चलाने के लिए Google सहयोग का उपयोग कर रहे हैं। Google Colab या Colaboratory ब्राउज़र पर पायथन कोड चलाने में मदद करता है और इसके लिए शून्य कॉन्फ़िगरेशन और GPU (ग्राफ़िकल प्रोसेसिंग यूनिट) तक मुफ्त पहुंच की आवश्यकता होती है। जुपिटर नोटबुक के ऊपर कोलैबोरेटरी बनाई गई है।

टोकनाइजेशन एक स्ट्रिंग को टोकन में तोड़ने की विधि है। ये टोकन शब्द, संख्या या विराम चिह्न हो सकते हैं। प्रमुख इंटरफेस में टोकेनाइज़र और टोकेनाइज़रविथऑफ़सेट शामिल हैं, जिनमें से प्रत्येक में क्रमशः एक ही विधि टोकननाइज़ और टोकनाइज़_विथ_ऑफ़सेट हैं। कई टोकननाइज़र हैं, जिनमें से प्रत्येक TokenizerWithOffsets (जो Tokenizer वर्ग का विस्तार करता है) को लागू करता है। इसमें मूल स्ट्रिंग में बाइट ऑफ़सेट प्राप्त करने का विकल्प शामिल है। यह मूल स्ट्रिंग में बाइट्स को जानने में मदद करता है जिससे टोकन बनाया गया था।

एन-ग्राम अनुक्रमिक शब्द हैं जब आकार n की एक स्लाइडिंग विंडो दी जाती है। जब टोकन संयुक्त होते हैं, तो तीन कमी तंत्र समर्थित होते हैं। पाठ के लिए, कमी.STRING_JOIN का उपयोग किया जा सकता है। यह तारों को एक दूसरे से जोड़ता है। डिफॉल्ट सेपरेटर कैरेक्टर स्पेस है, लेकिन इसे string_separater तर्क से बदला जा सकता है।

अन्य कमी विधियों का उपयोग संख्यात्मक मानों के साथ किया जाता है, और वे हैं रिडक्शन.एसयूएम और रिडक्शन। मीन।

उदाहरण

print("Whitespace tokenizer is being called")

tokenizer = text.WhitespaceTokenizer()

tokens = tokenizer.tokenize(['Everything not saved will be lost.', u'Sad☹'.encode('UTF-8')])

print("Here, n is 2, hence it is bigram")

bigrams = text.ngrams(tokens, 2, reduction_type=text.Reduction.STRING_JOIN)

print("The bigrams are converted to a list")

print(bigrams.to_list()) आउटपुट

Whitespace tokenizer is being called Here, n is 2, hence it is bigram The bigrams are converted to a list [[b'Everything not', b'not saved', b'saved will', b'will be', b'be lost.'], []]

स्पष्टीकरण

- व्हाट्सएप टोकननाइज़र कहा जाता है।

- 'n' का मान 2 पर सेट होता है, इसलिए इसे एक बिग्राम कहा जाता है।

- टोकन एक सूची में संग्रहीत होते हैं, और एक कंसोल पर प्रदर्शित होते हैं।