UTF-8 स्ट्रिंग्स को Tensorflow टेक्स्ट का उपयोग करके विभाजित किया जा सकता है। यह 'यूनिकोडस्क्रिप्टटोकनाइज़र' की मदद से किया जा सकता है। 'यूनिकोडस्क्रिप्टटोकनाइज़र' एक टोकननाइज़र है जिसे बनाया जाता है, जिसके बाद स्ट्रिंग पर 'यूनिकोडस्क्रिप्टटोकनाइज़र' में मौजूद 'टोकनाइज़' विधि को कॉल किया जाता है।

और पढ़ें: TensorFlow क्या है और Keras कैसे तंत्रिका नेटवर्क बनाने के लिए TensorFlow के साथ काम करता है?

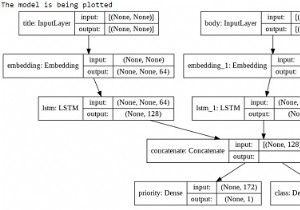

हम केरस अनुक्रमिक एपीआई का उपयोग करेंगे, जो एक अनुक्रमिक मॉडल बनाने में सहायक है जिसका उपयोग परतों के एक सादे ढेर के साथ काम करने के लिए किया जाता है, जहां हर परत में ठीक एक इनपुट टेंसर और एक आउटपुट टेंसर होता है।

एक तंत्रिका नेटवर्क जिसमें कम से कम एक परत होती है, एक दृढ़ परत के रूप में जानी जाती है। हम लर्निंग मॉडल बनाने के लिए कन्वेन्शनल न्यूरल नेटवर्क का उपयोग कर सकते हैं।

TensorFlow Text में टेक्स्ट से संबंधित क्लासेस और ऑप्स का संग्रह होता है जिसका उपयोग TensorFlow 2.0 के साथ किया जा सकता है। TensorFlow टेक्स्ट का उपयोग अनुक्रम मॉडलिंग को प्रीप्रोसेस करने के लिए किया जा सकता है।

हम नीचे दिए गए कोड को चलाने के लिए Google सहयोग का उपयोग कर रहे हैं। Google Colab या Colaboratory ब्राउज़र पर पायथन कोड चलाने में मदद करता है और इसके लिए शून्य कॉन्फ़िगरेशन और GPU (ग्राफ़िकल प्रोसेसिंग यूनिट) तक मुफ्त पहुंच की आवश्यकता होती है। जुपिटर नोटबुक के ऊपर कोलैबोरेटरी बनाई गई है।

टोकनाइजेशन एक स्ट्रिंग को टोकन में तोड़ने की विधि है। ये टोकन शब्द, संख्या या विराम चिह्न हो सकते हैं।

महत्वपूर्ण इंटरफेस में Tokenizer और TokenizerWithOffsets शामिल हैं, जिनमें से प्रत्येक में क्रमशः एक ही विधि टोकननाइज़ और tokenize_with_offsets है। कई टोकननाइज़र हैं, जिनमें से प्रत्येक TokenizerWithOffsets (जो Tokenizer वर्ग का विस्तार करता है) को लागू करता है। इसमें मूल स्ट्रिंग में बाइट ऑफ़सेट प्राप्त करने का विकल्प शामिल है। यह मूल स्ट्रिंग में बाइट्स को जानने में मदद करता है जिससे टोकन बनाया गया था।

सभी टोकनर रैगेडटेन्सर्स को टोकन के आंतरिक-अधिकतम आयाम के साथ लौटाते हैं जो मूल व्यक्तिगत स्ट्रिंग्स में मैप किए जाते हैं। परिणामी आकार की रैंक एक से बढ़ जाती है।

उदाहरण

print("Unicode script tokenizer is being called")

tokenizer = text.UnicodeScriptTokenizer()

tokens = tokenizer.tokenize(['everything not saved will be lost.', u'Sad☹'.encode('UTF-8')])

print("The tokenized data is converted to a list")

print(tokens.to_list()) कोड क्रेडिट -https://www.tensorflow.org/tutorials/tensorflow_text/intro

आउटपुट

Unicode script tokenizer is being called The tokenized data is converted to a list [[b'everything', b'not', b'saved', b'will', b'be', b'lost', b'.'], [b'Sad', b'\xe2\x98\xb9']]

स्पष्टीकरण

-

टोकननाइज़र यूनिकोड स्क्रिप्ट की सीमाओं के आधार पर UTF-8 स्ट्रिंग्स को विभाजित करता है।

-

स्क्रिप्ट कोड यूनिकोड (ICU) UScriptCode मानों के लिए अंतर्राष्ट्रीय घटकों के अनुरूप हैं।

-

यह व्हॉट्सएपटोकनाइज़र के समान है, इस अंतर के साथ कि यह भाषा के पाठों से विराम चिह्न (USCRIPT_COMMON) को और साथ ही एक दूसरे से अलग भाषा पाठों को विभाजित करेगा।