फ्लावर डेटासेट को बफर प्रीफेच, शफल विधि और कैशे विधि की मदद से प्रदर्शन के लिए कॉन्फ़िगर किया जा सकता है। बफर्ड प्रीफ़ेचिंग का उपयोग यह सुनिश्चित करने के लिए किया जा सकता है कि डेटा I/O ब्लॉक किए बिना डिस्क से लिया जा सकता है। Dataset.cache() पहले युग के दौरान डिस्क से लोड होने के बाद छवियों को स्मृति में रखता है। Dataset.prefetch() प्रशिक्षण के दौरान डेटा प्रीप्रोसेसिंग और मॉडल निष्पादन को ओवरलैप करेगा।

और पढ़ें: TensorFlow क्या है और Keras कैसे तंत्रिका नेटवर्क बनाने के लिए TensorFlow के साथ काम करता है?

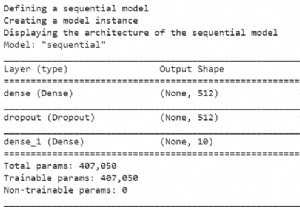

केरस अनुक्रमिक एपीआई का उपयोग किया जाता है, जो एक अनुक्रमिक मॉडल बनाने में सहायक होता है जिसका उपयोग परतों के एक सादे ढेर के साथ काम करने के लिए किया जाता है, जहां हर परत में ठीक एक इनपुट टेंसर और एक आउटपुट टेंसर होता है।

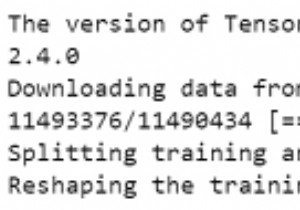

हम नीचे दिए गए कोड को चलाने के लिए Google सहयोग का उपयोग कर रहे हैं। Google Colab या Colaboratory ब्राउज़र पर पायथन कोड चलाने में मदद करता है और इसके लिए शून्य कॉन्फ़िगरेशन और GPU (ग्राफ़िकल प्रोसेसिंग यूनिट) तक मुफ्त पहुंच की आवश्यकता होती है। जुपिटर नोटबुक के ऊपर कोलैबोरेटरी बनाई गई है।

print("Configuring the dataset for better performance")

AUTOTUNE = tf.data.AUTOTUNE

train_ds = train_ds.cache().shuffle(1000).prefetch(buffer_size=AUTOTUNE)

val_ds = val_ds.cache().prefetch(buffer_size=AUTOTUNE) कोड क्रेडिट:https://www.tensorflow.org/tutorials/images/classification

आउटपुट

Configuring the dataset for better performance

स्पष्टीकरण

- बफ़र्ड प्रीफ़ेचिंग की अवधारणा का उपयोग किया जा सकता है ताकि डेटा I/O अवरुद्ध हुए बिना डिस्क से लिया जा सके।

- डेटा लोड करते समय दो महत्वपूर्ण विधियों का उपयोग किया जा सकता है।

- cache() छवियों को पहले युग के दौरान डिस्क से लोड किए जाने के बाद स्मृति में रखता है।

- यह सुनिश्चित करेगा कि जब मॉडल को प्रशिक्षित किया जा रहा हो तो डेटासेट बाधा न बने।

- यदि डेटासेट मेमोरी में फ़िट होने के लिए बहुत बड़ा है, तो इस विधि का उपयोग डिस्क पर प्रदर्शन करने वाला कैश बनाने के लिए किया जा सकता है।

- प्रीफ़ेच() प्रशिक्षण के दौरान डेटा प्रीप्रोसेसिंग और मॉडल निष्पादन को ओवरलैप करेगा।