क्या आप अपनी SEO रैंकिंग, एक्सपोज़र और रूपांतरणों को बेहतर बनाने के लिए टूल की तलाश कर रहे हैं? ऐसा करने के लिए, आपको एक वेब क्रॉलर टूल की आवश्यकता है। वेब क्रॉलर एक कंप्यूटर प्रोग्राम है जो इंटरनेट को स्कैन करता है। वेब स्पाइडर, वेब डेटा निष्कर्षण सॉफ्टवेयर और वेबसाइट स्क्रैपिंग प्रोग्राम इंटरनेट वेब क्रॉलिंग तकनीकों के उदाहरण हैं। इसे स्पाइडर बॉट या स्पाइडर के नाम से भी जाना जाता है। आज, हम डाउनलोड करने के लिए कुछ निःशुल्क वेब क्रॉलर टूल देखेंगे।

25 सर्वश्रेष्ठ निःशुल्क वेब क्रॉलर टूल

वेब क्रॉलर टूल डेटा माइनिंग और विश्लेषण के लिए जानकारी का खजाना प्रदान करते हैं। इसका प्राथमिक उद्देश्य इंटरनेट पर वेब पेजों को अनुक्रमित करना है। यह टूटे हुए लिंक, डुप्लिकेट सामग्री और लापता पृष्ठ शीर्षक का पता लगा सकता है और गंभीर एसईओ मुद्दों की पहचान कर सकता है। ऑनलाइन डेटा को स्क्रैप करने से आपके व्यवसाय को कई तरह से लाभ हो सकता है।

- कई वेब क्रॉलर ऐप्स किसी भी वेबसाइट URL से डेटा को ठीक से क्रॉल कर सकते हैं।

- ये कार्यक्रम आपकी वेबसाइट की संरचना में सुधार करने में आपकी सहायता करते हैं ताकि खोज इंजन इसे समझ सकें और आपकी रैंकिंग बढ़ा सकें।

हमारे शीर्ष टूल की सूची में, हमने वेब क्रॉलर टूल मुफ्त डाउनलोड और उनकी सुविधाओं और लागतों की एक सूची तैयार की है, जिसमें से आप चुन सकते हैं। सूची में देय आवेदन भी शामिल हैं।

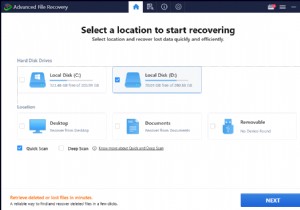

1. खोज सर्वर खोलें

OpenSearchServer एक निःशुल्क वेब क्रॉलर है और इंटरनेट पर इसकी शीर्ष रेटिंग में से एक है। उपलब्ध सर्वोत्तम विकल्पों में से एक।

- यह एक पूरी तरह से एकीकृत समाधान . है ।

- खुला खोज सर्वर एक वेब क्रॉलिंग और खोज इंजन है जो मुफ़्त और खुला स्रोत है।

- यह वन-स्टॉप और किफ़ायती समाधान है।

- यह खोज क्षमताओं के व्यापक सेट और अपनी खुद की अनुक्रमण रणनीति बनाने की संभावना के साथ आता है।

- क्रॉलर किसी भी चीज़ को इंडेक्स कर सकते हैं।

- पूर्ण-पाठ, बूलियन और ध्वन्यात्मक खोजें हैं चुनने के लिए।

- आप 17 विभिन्न भाषाओं में से चुन सकते हैं ।

- स्वचालित वर्गीकरण किए जाते हैं।

- आप अक्सर होने वाली चीजों के लिए एक समय सारिणी बना सकते हैं।

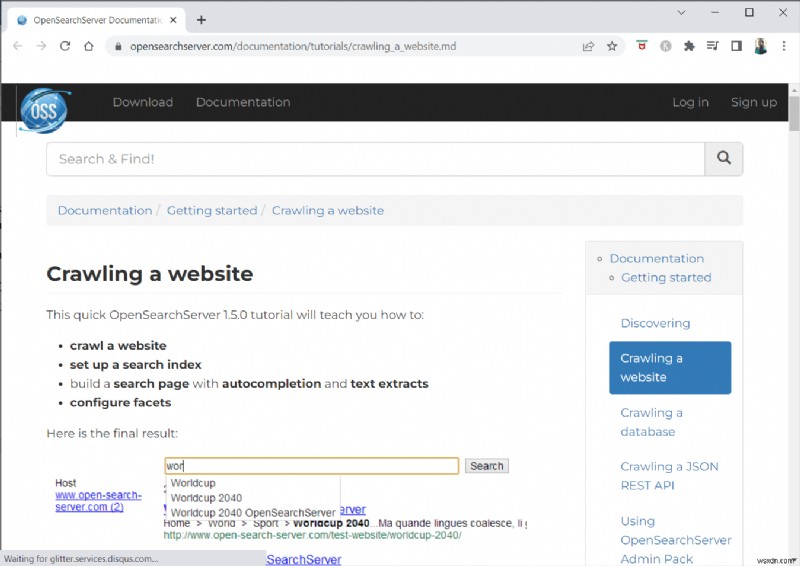

2. Spinn3r

Spinn3r वेब क्रॉलर प्रोग्राम आपको ब्लॉग, समाचार, सोशल नेटवर्किंग साइट, RSS फ़ीड और ATOM फ़ीड से पूरी तरह से सामग्री निकालने की अनुमति देता है। ।

- यह एक लाइटनिंग-फास्ट एपीआई के साथ आता है जो संभालता है 95% अनुक्रमण कार्य का ।

- उन्नत स्पैम सुरक्षा इस वेब क्रॉलिंग एप्लिकेशन में शामिल है, जो स्पैम और अनुचित भाषा के उपयोग को हटाता है, डेटा सुरक्षा में सुधार करता है।

- वेब स्क्रैपर आपको रीयल-टाइम सामग्री के साथ प्रस्तुत करने के लिए कई स्रोतों से अपडेट के लिए लगातार वेब को खंगालता है।

- यह सामग्री को उसी तरह अनुक्रमित करता है जैसे Google करता है, और निकाले गए डेटा को JSON फ़ाइलों के रूप में सहेजा जाता है।

- पार्सर एपीआई आपको मनमाने वेब यूआरएल के लिए जानकारी को जल्दी से पार्स और प्रबंधित करने की अनुमति देता है।

- फायरहोज एपीआई डेटा की भारी मात्रा में बड़े पैमाने पर पहुंच के लिए डिज़ाइन किया गया है।

- साधारण HTTP शीर्षलेखों का उपयोग किया जाता है Spinn3r के सभी API को प्रमाणित करने के लिए।

- यह मुफ्त डाउनलोड के लिए एक वेब क्रॉलर टूल है।

- क्लासिफायर एपीआई डेवलपर्स को हमारी मशीन लर्निंग तकनीक द्वारा लेबल किए जाने वाले टेक्स्ट (या यूआरएल) को प्रसारित करने में सक्षम बनाता है।

3. Import.io

Import.io आपको लाखों वेब पेजों को मिनटों में स्क्रैप करने और कोड की एक भी लाइन लिखे बिना आपकी आवश्यकताओं के आधार पर 1000+ API बनाने की अनुमति देता है।

- अब इसे प्रोग्रामेटिक रूप से संचालित किया जा सकता है, और डेटा अब स्वचालित रूप से पुनर्प्राप्त किया जा सकता है।

- एक बटन के झटके से कई पृष्ठों से डेटा निकालें।

- यह पृष्ठांकित सूचियों को स्वचालित रूप से पहचान सकता है , या आप अगले पृष्ठ पर क्लिक कर सकते हैं।

- आप केवल कुछ क्लिक के साथ अपने ऐप या वेबसाइट में ऑनलाइन डेटा शामिल कर सकते हैं।

- पृष्ठ संख्या और श्रेणी के नाम जैसे पैटर्न का उपयोग करके कुछ ही सेकंड में सभी URL बनाएं जिनकी आपको आवश्यकता है।

- Import.io यह प्रदर्शित करता है कि किसी पृष्ठ से सीधे डेटा कैसे निकाला जाए। बस अपने डेटासेट से एक कॉलम चुनें और पेज पर किसी ऐसी चीज़ की ओर इशारा करें जो आपकी नज़र में आए।

- आप उनकी वेबसाइट पर उद्धरण प्राप्त कर सकते हैं ।

- सूची पृष्ठों के लिंक अधिक जानकारी वाले विस्तृत पृष्ठों पर ले जाते हैं।

- विवरण पृष्ठों से एक ही बार में सभी डेटा प्राप्त करने के लिए आप उनमें शामिल होने के लिए Import.io का उपयोग कर सकते हैं।

4. बुबिंग

BUbiNG, अगली पीढ़ी का वेब क्रॉलर टूल है, जो UbiCrawler के साथ लेखकों के अनुभव और विषय में दस वर्षों के शोध की परिणति है।

- होस्ट और आईपी-आधारित दोनों तरह के सख्त शिष्टाचार मानकों का पालन करते हुए एक एजेंट द्वारा प्रति सेकंड हजारों पृष्ठों को क्रॉल किया जा सकता है।

- इसका कार्य वितरण, बैच तकनीकों पर निर्भर पहले के ओपन-सोर्स वितरित क्रॉलर के विपरीत, बहुत उच्च थ्रूपुट देने के लिए समकालीन हाई-स्पीड प्रोटोकॉल पर बनाया गया है।

- यह निकट-डुप्लिकेट का पता लगाने के लिए एक स्ट्रिप किए गए पृष्ठ के फ़िंगरप्रिंट का उपयोग करता है ।

- BUbiNG पूरी तरह से वितरित ओपन-सोर्स जावा क्रॉलर . है ।

- इसमें बहुत समानताएं हैं।

- ऐसे बहुत से लोग हैं जो इस उत्पाद का उपयोग करते हैं।

- यह तेज़ है।

- यह बड़े पैमाने पर क्रॉलिंग को सक्षम करता है ।

5. GNU Wget

GNU Wget एक मुफ्त वेब क्रॉलर टूल मुफ्त डाउनलोड उपलब्ध है, और यह C में लिखा गया एक ओपन-सोर्स सॉफ़्टवेयर प्रोग्राम है जो आपको HTTP, HTTPS, FTP, और FTPS के माध्यम से फ़ाइलें प्राप्त करने की अनुमति देता है। ।

- इस एप्लिकेशन के सबसे विशिष्ट पहलुओं में से एक विभिन्न भाषाओं में एनएलएस-आधारित संदेश फ़ाइलें बनाने की क्षमता है।

- आप डाउनलोड फिर से शुरू कर सकते हैं जिन्हें REST और RANGE . का उपयोग करके रोक दिया गया है ।

- यदि आवश्यक हो तो यह डाउनलोड किए गए दस्तावेज़ों में पूर्ण लिंक को सापेक्ष लिंक में भी बदल सकता है।

- फ़ाइल नाम और मिरर निर्देशिकाओं में वाइल्डकार्ड का पुनरावर्ती रूप से उपयोग करें।

- विभिन्न भाषाओं के लिए NLS पर आधारित संदेश फ़ाइलें।

- प्रतिबिंबित करते समय, स्थानीय फ़ाइल टाइमस्टैम्प का मूल्यांकन किया जाता है यह निर्धारित करने के लिए कि क्या दस्तावेज़ों को फिर से डाउनलोड करने की आवश्यकता है।

6. Webhose.io

Webhose.io एक शानदार वेब क्रॉलर एप्लिकेशन है जो आपको कई भाषाओं में डेटा स्कैन करने और कीवर्ड निकालने की सुविधा देता है। स्रोतों की एक विस्तृत श्रृंखला में फैले विभिन्न फ़िल्टरों का उपयोग करना।

- संग्रह उपयोगकर्ताओं को पिछला डेटा देखने . की अनुमति भी देता है ।

- इसके अलावा, webhose.io की क्रॉलिंग डेटा खोजें 80 भाषाओं तक उपलब्ध हैं ।

- व्यक्तिगत रूप से पहचानी जा सकने वाली सभी जानकारी जिससे छेड़छाड़ की गई है, एक ही स्थान पर मिल सकती है।

- साइबर खतरों के लिए डार्कनेट और मैसेजिंग एप्लिकेशन की जांच करें।

- XML, JSON, और RSS प्रारूप स्क्रैप किए गए डेटा के लिए भी पहुंच योग्य हैं।

- आप उनकी वेबसाइट पर एक उद्धरण प्राप्त कर सकते हैं।

- उपयोगकर्ता बस Webhose.io पर संरचित डेटा को अनुक्रमित और खोज सकते हैं।

- सभी भाषाओं में, यह मीडिया आउटलेट की निगरानी और विश्लेषण कर सकता है।

- संदेश बोर्डों और मंचों पर चर्चाओं का पालन करना संभव है।

- यह आपको पूरे वेब से प्रमुख ब्लॉग पोस्ट का ट्रैक रखने की अनुमति देता है।

7. नॉरकोनेक्स

ओपन-सोर्स वेब क्रॉलर ऐप की तलाश करने वाले व्यवसायों के लिए नॉरकोनेक्स एक उत्कृष्ट संसाधन है।

- इस पूर्ण विशेषताओं वाले संग्राहक का उपयोग या आपके कार्यक्रम में एकीकृत किया जा सकता है।

- इसमें पेज की चुनिंदा छवि भी लग सकती है ।

- Norconex आपको किसी भी वेबसाइट की सामग्री को क्रॉल करने की क्षमता देता है।

- किसी भी ऑपरेटिंग सिस्टम का उपयोग करना संभव है।

- यह वेब क्रॉलर सॉफ़्टवेयर एक औसत क्षमता वाले सर्वर पर लाखों पृष्ठों को क्रॉल कर सकता है।

- इसमें सामग्री और मेटाडेटा को संशोधित करने के लिए उपकरणों का एक सेट भी शामिल है।

- उन दस्तावेज़ों के लिए मेटाडेटा प्राप्त करें जिन पर आप वर्तमान में काम कर रहे हैं।

- JavaScript-रेंडर किए गए पेज समर्थित हैं।

- यह कई भाषाओं का पता लगाने में सक्षम बनाता है।

- यह अनुवाद सहायता सक्षम करता है।

- जिस गति से आप क्रॉल करते हैं उसे बदला जा सकता है।

- दस्तावेज जिन्हें संशोधित या हटा दिया गया है, उनकी पहचान की जाती है।

- यह पूरी तरह से मुफ़्त वेब क्रॉलर प्रोग्राम है।

8. Dexi.io

Dexi.io एक ब्राउज़र-आधारित वेब क्रॉलर ऐप है जो आपको किसी भी वेबसाइट से जानकारी को परिमार्जन करने की अनुमति देता है।

- निकालने वाले, क्रॉलर और पाइप तीन प्रकार के रोबोट हैं जिनका उपयोग आप स्क्रैपिंग ऑपरेशन करने के लिए कर सकते हैं।

- डेल्टा रिपोर्ट का उपयोग करके बाजार के विकास का पूर्वानुमान लगाया जाता है।

- आपका एकत्रित डेटा संग्रह करने से पहले Dexi.io के सर्वर पर दो सप्ताह तक सुरक्षित रहेगा, या आप निकाले गए डेटा को तुरंत JSON या CSV फ़ाइलों के रूप में निर्यात कर सकते हैं ।

- आप उनकी वेबसाइट पर एक उद्धरण प्राप्त कर सकते हैं।

- गुणवत्ता आश्वासन और चल रहे रखरखाव जैसी पेशेवर सेवाएं प्रदान की जाती हैं।

- यह आपकी रीयल-टाइम डेटा आवश्यकताओं को पूरा करने में आपकी सहायता करने के लिए वाणिज्यिक सेवाएं प्रदान करता है।

- एक एसकेयू/उत्पादों की असीमित संख्या के लिए स्टॉक और मूल्य निर्धारण को ट्रैक करना संभव है ।

- यह आपको लाइव डैशबोर्ड और संपूर्ण उत्पाद विश्लेषण का उपयोग करके डेटा को एकीकृत करने की अनुमति देता है।

- यह आपको वेब-आधारित संगठित और उपयोग के लिए तैयार उत्पाद डेटा तैयार करने और कुल्ला करने में मदद करता है।

9. ज़ाइटे

Zyte एक क्लाउड-आधारित डेटा निष्कर्षण उपकरण है जो महत्वपूर्ण जानकारी का पता लगाने के लिए हजारों डेवलपर्स की सहायता करता है। यह सर्वश्रेष्ठ मुफ्त वेब क्रॉलर ऐप में से एक है।

- उपयोगकर्ता किसी भी कोडिंग को जाने बिना इसके ओपन-सोर्स विज़ुअल स्क्रैपिंग एप्लिकेशन का उपयोग करके वेबपेजों को स्क्रैप कर सकते हैं।

- क्रॉलेरा , Zyte द्वारा उपयोग किया जाने वाला एक जटिल प्रॉक्सी रोटेटर , उपयोगकर्ताओं को बड़ी या बॉट-संरक्षित साइटों को आसानी से क्रॉल करने की अनुमति देता है, जबकि बॉट प्रति-उपायों से बचता है।

- आपकी ऑनलाइन जानकारी समय पर और लगातार वितरित की जाती है। नतीजतन, प्रॉक्सी को प्रबंधित करने के बजाय, आप डेटा प्राप्त करने पर ध्यान केंद्रित कर सकते हैं।

- स्मार्ट ब्राउज़र क्षमताओं और रेंडरिंग के कारण, ब्राउज़र परत को लक्षित करने वाले एंटीबॉडी को अब आसानी से प्रबंधित किया जा सकता है।

- उनकी वेबसाइट पर, आपको एक उद्धरण मिल सकता है।

- उपयोगकर्ता एक साधारण HTTP API का उपयोग करके अनेक IP और क्षेत्रों से क्रॉल कर सकते हैं , प्रॉक्सी रखरखाव की आवश्यकता को समाप्त करना।

- यह आपको आवश्यक जानकारी प्राप्त करके समय बचाने के साथ-साथ नकदी उत्पन्न करने में मदद करता है।

- यह आपको कोडिंग और स्पाइडर रखरखाव पर समय बचाते हुए बड़े पैमाने पर वेब डेटा निकालने की अनुमति देता है।

10. अपाचे नच

अपाचे नच निर्विवाद रूप से सबसे महान ओपन सोर्स वेब क्रॉलर ऐप की सूची में सबसे ऊपर है।

- यह एक मशीन पर काम कर सकता है। हालांकि, यह Hadoop क्लस्टर पर सबसे अच्छा प्रदर्शन करता है।

- प्रमाणीकरण के लिए, NTLM प्रोटोकॉल कार्यरत है।

- इसमें एक वितरित फ़ाइल सिस्टम (Hadoop के माध्यम से) है।

- यह एक प्रसिद्ध ओपन-सोर्स ऑनलाइन डेटा निष्कर्षण सॉफ़्टवेयर प्रोजेक्ट है जो डेटा माइनिंग के लिए अनुकूलनीय और स्केलेबल है ।

- कई डेटा विश्लेषक इसका उपयोग करते हैं, वैज्ञानिक, एप्लिकेशन डेवलपर, और पूरी दुनिया में वेब टेक्स्ट माइनिंग विशेषज्ञ।

- यह एक जावा-आधारित क्रॉस-प्लेटफ़ॉर्म समाधान है ।

- डिफ़ॉल्ट रूप से, फ़ेचिंग और पार्सिंग स्वतंत्र रूप से की जाती है।

- डेटा को XPath और नामस्थान का उपयोग करके मैप किया जाता है ।

- इसमें एक लिंक ग्राफ डेटाबेस होता है।

11. विजुअलस्क्रेपर

VisualScraper इंटरनेट से डेटा निकालने के लिए एक और शानदार गैर-कोडिंग वेब स्क्रैपर है।

- यह एक सरल बिंदु-और-क्लिक उपयोगकर्ता इंटरफ़ेस प्रदान करता है ।

- यह डेटा प्रसार और सॉफ्टवेयर एक्सट्रैक्टर्स के निर्माण जैसी ऑनलाइन स्क्रैपिंग सेवाएं भी प्रदान करता है।

- यह आपके प्रतिस्पर्धियों पर भी नजर रखता है।

- उपयोगकर्ता अपनी परियोजनाओं को एक निश्चित समय पर चलाने के लिए शेड्यूल कर सकते हैं या दृश्य स्क्रैपर के साथ हर मिनट, दिन, सप्ताह, महीने और वर्ष में अनुक्रम दोहरा सकते हैं।

- यह कम खर्चीला होने के साथ-साथ अधिक प्रभावी भी है।

- बोलने के लिए कोई कोड भी नहीं है।

- यह पूरी तरह से मुफ़्त वेब क्रॉलर प्रोग्राम है।

- कई वेब पेजों से रीयल-टाइम डेटा निकाला जा सकता है और CSV, XML, JSON, या SQL फ़ाइलों के रूप में सहेजा जा सकता है ।

- उपयोगकर्ता इसका उपयोग नियमित रूप से समाचार, अपडेट और फ़ोरम पोस्ट निकालने के लिए कर सकते हैं ।

- डेटा 100% सटीक और अनुकूलित . है ।

12. वेबस्फिंक्स

WebSphinx एक शानदार व्यक्तिगत मुफ़्त वेब क्रॉलर ऐप है जिसे सेट करना और उपयोग करना आसान है।

- यह परिष्कृत वेब उपयोगकर्ताओं और जावा प्रोग्रामर के लिए डिज़ाइन किया गया है जो इंटरनेट के एक सीमित हिस्से को स्वचालित रूप से स्कैन करना चाहते हैं। ।

- इस ऑनलाइन डेटा निष्कर्षण समाधान में जावा क्लास लाइब्रेरी और एक इंटरैक्टिव प्रोग्रामिंग वातावरण शामिल है।

- पृष्ठों को एक ही दस्तावेज़ बनाने के लिए संयोजित किया जा सकता है जिसे ब्राउज़ या मुद्रित किया जा सकता है।

- सभी टेक्स्ट निकालें जो पृष्ठों के अनुक्रम से दिए गए पैटर्न में फिट बैठता है।

- वेब क्रॉलर अब इस पैकेज की बदौलत जावा में लिखे जा सकते हैं।

- द क्रॉलर वर्कबेंच और WebSPHINX क्लास लाइब्रेरी दोनों WebSphinx में शामिल हैं।

- क्रॉलर वर्कबेंच एक ग्राफिकल यूजर इंटरफेस है जो आपको वेब क्रॉलर को अनुकूलित और संचालित करने की अनुमति देता है।

- वेब पेजों के समूह से एक ग्राफ बनाया जा सकता है।

- ऑफ़लाइन पढ़ने के लिए पृष्ठों को अपने स्थानीय ड्राइव में सहेजें।

13. आउटविट हब

आउटविट हब प्लेटफ़ॉर्म में एक कर्नेल होता है जिसमें डेटा पहचान और निष्कर्षण क्षमताओं की एक विस्तृत लाइब्रेरी होती है, जिस पर विभिन्न ऐप्स की एक अंतहीन संख्या बनाई जा सकती है, प्रत्येक कर्नेल की विशेषताओं का उपयोग करता है।

- यह वेब क्रॉलर एप्लिकेशन साइटों के माध्यम से स्कैन कर सकता है और डेटा को संरक्षित कर सकता है यह एक सुलभ तरीके से खोजता है।

- यह एक बहुउद्देशीय हार्वेस्टर है जिसमें विभिन्न आवश्यकताओं को पूरा करने के लिए यथासंभव अधिक सुविधाएं हैं।

- हब को काफी समय हो गया है।

- यह गैर-तकनीकी उपयोगकर्ताओं और आईटी पेशेवरों के लिए एक उपयोगी और विविध मंच के रूप में विकसित हुआ है जो कोड करना जानते हैं लेकिन यह मानते हैं कि डेटा निकालने के लिए PHP हमेशा आदर्श विकल्प नहीं होता है।

- आउटविट हब मामूली या भारी मात्रा में डेटा को स्क्रैप करने के लिए एकल इंटरफ़ेस प्रदान करता है आपकी मांगों के आधार पर।

- यह आपको ब्राउज़र से सीधे किसी भी वेब पेज को स्क्रैप करने और डेटा को हथियाने और इसे आपकी आवश्यकताओं के अनुसार तैयार करने वाले स्वचालित एजेंटों का निर्माण करने में सक्षम बनाता है।

- आप एक उद्धरण प्राप्त कर सकते हैं उनकी वेबसाइट पर।

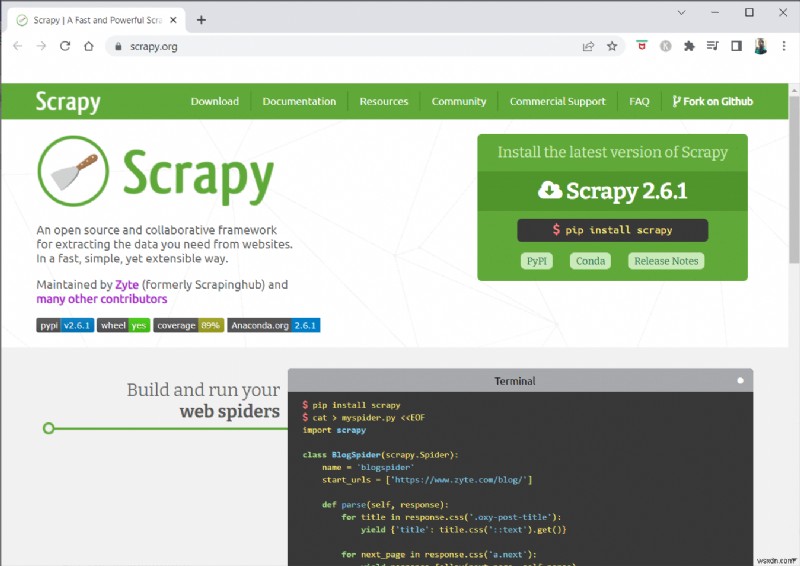

14. स्क्रैपी

स्क्रेपी स्केलेबल वेब क्रॉलर बनाने के लिए एक पायथन ऑनलाइन स्क्रैपिंग ढांचा है।

- यह एक संपूर्ण वेब क्रॉलिंग ढांचा है जो उन सभी विशेषताओं को संभालता है जो वेब क्रॉलर को बनाना मुश्किल बनाती हैं, जैसे कि प्रॉक्सी मिडलवेयर और क्वेरी प्रश्न ।

- आप डेटा निकालने के लिए नियम लिख सकते हैं और फिर स्क्रेपी को बाकी काम करने दें।

- कोर को संशोधित किए बिना नई सुविधाओं को जोड़ना आसान है क्योंकि इसे इस तरह से डिज़ाइन किया गया है।

- यह एक पायथन-आधारित प्रोग्राम है जो लिनक्स, विंडोज, मैक ओएस एक्स, और बीएसडी सिस्टम पर संचालित होता है ।

- यह पूरी तरह से निःशुल्क उपयोगिता है।

- इसकी लाइब्रेरी वेब क्रॉलर को अनुकूलित करने और बड़े पैमाने पर वेब से डेटा निकालने के लिए प्रोग्रामर को उपयोग के लिए तैयार संरचना प्रदान करती है।

15. मोज़ेंडा

Mozenda भी सबसे अच्छा फ्री वेब क्रॉलर ऐप है। यह एक व्यवसाय-उन्मुख क्लाउड-आधारित स्वयं-सेवा वेब स्क्रैपिंग प्रोग्राम है। Mozenda के 7 बिलियन से अधिक पृष्ठ स्क्रैप किए गए हैं और दुनिया भर में इसके कॉर्पोरेट ग्राहक हैं।

- मोज़ेंडा की वेब स्क्रैपिंग तकनीक स्क्रिप्ट और इंजीनियरों की भर्ती की आवश्यकता को हटा देती है।

- यह डेटा संग्रहण को पांच गुना तेज करता है ।

- आप Mozenda की पॉइंट-एंड-क्लिक क्षमता वाली वेबसाइटों से टेक्स्ट, फ़ाइलें, चित्र और PDF जानकारी स्क्रैप कर सकते हैं।

- डेटा फ़ाइलों को व्यवस्थित करके, आप उन्हें प्रकाशन के लिए तैयार कर सकते हैं।

- आप Mozeda के API का उपयोग करके सीधे TSV, CSV, XML, XLSX, या JSON को निर्यात कर सकते हैं ।

- आप अपनी जानकारी को व्यवस्थित करने के लिए मोज़ेंडा के परिष्कृत डेटा रैंगलिंग का उपयोग कर सकते हैं ताकि आप महत्वपूर्ण निर्णय ले सकें।

- आप कुछ प्लेटफ़ॉर्म में डेटा को एकीकृत करने या कस्टम डेटा एकीकरण स्थापित करने के लिए Mozenda के भागीदारों में से किसी एक प्लेटफ़ॉर्म का उपयोग कर सकते हैं।

16. सायटेक वेबकॉपी

Cyotek Webcopy एक निःशुल्क वेब क्रॉलर टूल है जो आपको किसी वेबसाइट की सामग्री को अपने स्थानीय डिवाइस पर स्वचालित रूप से डाउनलोड करने की अनुमति देता है।

- चुनी गई वेबसाइट की सामग्री को स्कैन और डाउनलोड किया जाएगा।

- आप चुन सकते हैं कि वेबसाइट के किन हिस्सों को क्लोन करना है और इसकी जटिल संरचना का उपयोग कैसे करना है।

- नया स्थानीय मार्ग स्टाइलशीट, चित्र, और अन्य पृष्ठों जैसे वेबसाइट संसाधनों के लिंक को पुनर्निर्देशित करेगा ।

- यह किसी वेबसाइट के HTML मार्कअप को देखेगा और अन्य वेबसाइट, फ़ोटो, वीडियो, फ़ाइल डाउनलोड जैसे किसी भी कनेक्टेड संसाधन को खोजने का प्रयास करेगा। , और इसी तरह।

- यह किसी वेबसाइट को क्रॉल कर सकता है और मूल की स्वीकार्य प्रतिलिपि बनाने के लिए जो कुछ भी देखता है उसे डाउनलोड कर सकता है।

17. सामान्य क्रॉल

सामान्य क्रॉल का उद्देश्य उपयोगी जानकारी प्राप्त करने के लिए डेटा की खोज और विश्लेषण में रुचि रखने वाले किसी भी व्यक्ति के लिए था।

- यह एक 501(c)(3) गैर-लाभकारी . है जो अपने संचालन को ठीक से चलाने के लिए दान पर निर्भर करता है।

- कोई भी व्यक्ति जो सामान्य क्रॉल का उपयोग करना चाहता है, वह बिना कोई पैसा खर्च किए या समस्या पैदा किए ऐसा कर सकता है।

- सामान्य क्रॉल एक संग्रह है जिसका उपयोग शिक्षण, शोध और विश्लेषण के लिए किया जा सकता है।

- यदि आपके पास सामान्य क्रॉल डेटा का उपयोग करके अन्य लोगों द्वारा की गई उल्लेखनीय खोजों के बारे में जानने के लिए कोई तकनीकी कौशल नहीं है, तो आपको लेख पढ़ना चाहिए।

- डेटा विश्लेषण सिखाने के लिए शिक्षक इन उपकरणों का उपयोग कर सकते हैं।

18. सेमरश

सेमरश एक वेबसाइट क्रॉलर ऐप है जो तकनीकी एसईओ मुद्दों के लिए आपकी वेबसाइट के पृष्ठों और संरचना की जांच करता है। इन समस्याओं को ठीक करने से आपको अपने खोज परिणामों को बेहतर बनाने में मदद मिल सकती है।

- इसमें SEO, मार्केट रिसर्च, सोशल मीडिया मार्केटिंग और विज्ञापन के लिए टूल हैं ।

- इसमें उपयोगकर्ता के अनुकूल UI है।

- मेटाडेटा, HTTP/HTTPS, निर्देश, स्थिति कोड, डुप्लिकेट सामग्री, पृष्ठ प्रतिक्रिया गति, आंतरिक लिंकिंग, छवि आकार, संरचित डेटा , और अन्य तत्वों की जांच की जाएगी।

- इससे आप अपनी वेबसाइट का तेजी से और सरलता से ऑडिट कर सकते हैं।

- यह लॉग फ़ाइलों के विश्लेषण में सहायता करता है ।

- यह प्रोग्राम एक डैशबोर्ड प्रदान करता है जो आपको वेबसाइट की समस्याओं को आसानी से देखने की अनुमति देता है।

19. Sitechecker.pro

Sitechecker.pro एक और बेहतरीन फ्री वेब क्रॉलर ऐप है। यह वेबसाइटों के लिए एक SEO चेकर है जो आपकी SEO रैंकिंग को बढ़ाने में आपकी मदद करता है।

- आप आसानी से वेब पेज की संरचना की कल्पना कर सकते हैं।

- यह एक ऑन-पेज SEO ऑडिट रिपोर्ट बनाता है जो ग्राहक ईमेल के माध्यम से प्राप्त कर सकते हैं।

- यह वेब क्रॉलर टूल आपकी वेबसाइट के आंतरिक और बाहरी लिंक को देख सकता है ।

- यह आपकी वेबसाइट की गति निर्धारित करने . में आपकी सहायता करता है ।

- लैंडिंग पृष्ठों पर अनुक्रमण समस्याओं की जांच करने के लिए आप Sitechecker.pro का उपयोग भी कर सकते हैं ।

- It helps you to defend against hacker attacks ।

20. Webharvy

Webharvy is a web scraping tool with a simple point-and-click interface. It’s designed for those who don’t know how to code.

- The cost of a license starts at $139 ।

- You’ll use WebHarvy’s built-in browser to load online sites and choose the data to be scraped using mouse clicks.

- It can automatically scrape text, photos, URLs, and emails from websites and save them in various formats.

- Proxy servers or a VPN can be used to access target websites.

- Scraping data does not necessitate the creation of any programming or apps.

- You may scrape anonymously and prevent web scraping software from being prohibited by web servers by using proxy servers or VPNs to access target websites.

- WebHarvy automatically identifies data patterns in websites.

- If you need to scrape a list of objects from a web page, you don’t need to do anything else.

21. NetSpeak Spider

NetSpeak Spider is a desktop web crawler app for daily SEO audits, quickly identifying problems, conducting systematic analysis, and scraping webpages ।

- This web crawling application excels at evaluating large web pages while minimizing RAM use.

- CSV files may be readily imported and exported from web crawling data.

- With just a few clicks, you may identify these and hundreds of severe other website SEO concerns.

- The tool will assist you in assessing a website’s on-page optimization, including the status code, crawling and indexing instructions, website structure, and redirects, among other things.

- Data from Google Analytics and Yandex may be exported.

- Take data range, device kind, and segmentation into account for your website pages, traffic, conversions, targets, and even E-commerce settings.

- Its monthly subscriptions begin at $21 ।

- Broken links and photos will be detected by the SEO crawler, as will duplicate material such as pages, texts, duplicate title and meta description tags, and H1s.

22. UiPath

UiPath is a web crawler online scraping tool that allows you to automate robotic procedures. It automates online and desktop data crawling for most third-party programs.

- You may install the robotic process automation application on Windows.

- It can extract data in tabular and pattern-based forms from many web pages.

- UiPath can conduct additional crawls right out of the box ।

- Reporting keeps track of your robots so that you may refer to the documentation at any time.

- Your outcomes will be more efficient and successful if you standardize your practices.

- Monthly subscriptions start at $420 ।

- The Marketplace’s more than 200 ready-made components provide your team with more time in less time.

- UiPath robots increase compliance by following the exact method that meets your needs.

- Companies may achieve rapid digital transformation at lower costs by optimizing processes, recognizing economies, and offering insights.

23. Helium Scraper

Helium Scraper is a visual online data web crawling application that works best when there is little association between elements. On a basic level, it could satisfy users’ crawling requirements.

- It does not necessitate any coding or configuration.

- A clear and easy user interface allows you to select and add activities from a specified list.

- Online templates are also available for specialized crawling requirements.

- Off-screen, several Chromium web browsers are utilized ।

- Increase the number of simultaneous browsers to obtain as much data as feasible.

- Define your own actions or utilize custom JavaScript for more complex instances.

- It may be installed on a personal computer or a dedicated Windows server.

- Its licenses start at $99 and go up from there.

24. 80Legs

In 2009, 80Legs was founded to make online data more accessible. It is another one of the best free web crawler tools. Initially, the firm focused on providing web crawling services to various clients.

- Our extensive web crawler app will provide you with personalized information.

- Crawling speed is automatically adjusted based on website traffic ।

- You can download findings to your local environment or computer via 80legs.

- By just providing a URL, you may crawl the website.

- Its monthly subscriptions start at $29 per month ।

- Through SaaS, it is possible to construct and conduct web crawls.

- It has many servers that let you view the site from various IP addresses.

- Get instant access to site data instead of scouring the web.

- It facilitates the construction and execution of customized web crawls.

- You may use this application to keep track of online trends ।

- You may make your templates if you want to.

25. ParseHub

ParseHub is an excellent web crawler app that can collect information from websites that use AJAX, JavaScript, cookies, and other related technologies.

- Its machine learning engine can read, evaluate, and convert online content into meaningful data ।

- You may also make use of the built-in web app in your browser.

- Obtaining information from millions of websites is possible.

- ParseHub will search through thousands of links and words automatically.

- Data is gathered and stored automatically on our servers.

- Monthly packages start at $149 ।

- As shareware, you can only build five public projects on ParseHub.

- You may use it to access drop-down menus, log on to websites, click on maps, and manage webpages using infinite scroll, tabs, and pop-ups ।

- ParseHub’s desktop client is available for Windows, Mac OS X, and Linux ।

- You may acquire your scraped data in any format for analysis.

- You can establish at least 20 private scraping projects with premium membership levels.

अनुशंसित:

- How to Delete DoorDash Account

- 31 Best Web Scraping Tools

- पीसी के लिए 24 सर्वश्रेष्ठ मुफ्त टाइपिंग सॉफ्टवेयर

- 15 Best File Compression Tools for Windows

We hope that this article was helpful and you have chosen your favorite free web crawler tool. Share your thoughts, queries, and suggestions in the comment section below. Also, you can suggest to us the missing tools. हमें बताएं कि आप आगे क्या सीखना चाहते हैं।