पर्याप्त स्रोत छवियों के साथ, जॉर्डन पील को राष्ट्रपति ओबामा, जिमी फॉलन को जॉन ओलिवर, या जॉन स्नो को निराश गेम ऑफ थ्रोन्स प्रशंसकों के प्रवक्ता के रूप में बनाना मुश्किल नहीं है। सबसे पहले, डीपफेक को पकड़ना बहुत कठिन नहीं था - यहां तक कि सबसे अच्छे लोगों के पास धुंधलापन, विकृति और चेहरे के अजीबोगरीब अंतर जैसे दृश्य उपहार थे, जो उन्हें "बंद" लगते थे।

हालाँकि, यह एक बिल्ली और चूहे का खेल है, और ऐसा लगता है कि जैसे ही हम डीपफेक का पता लगाने के लिए एक तरीका सीखते हैं, अगली पीढ़ी दोष को ठीक कर देती है। इससे लड़ने के लिए, क्या यह पता लगाने के लिए कोई विश्वसनीय समाधान हैं कि कौन से वीडियो हमें बरगलाने की कोशिश कर रहे हैं?

विज़ुअल सुराग

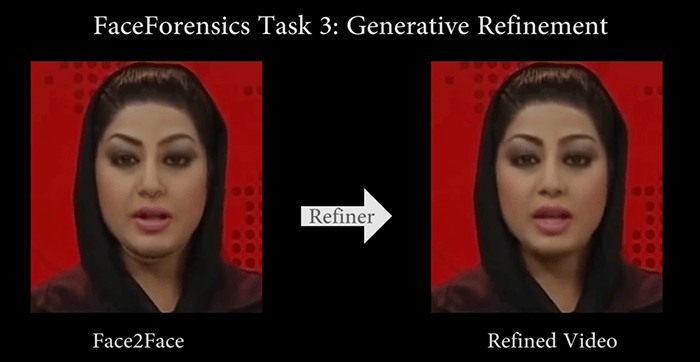

इंडियाना जोन्स संग्रहालयों में सिर्फ कलाकृतियां नहीं रखता है - एक छवि या वीडियो में हेरफेर किए जाने के बाद वे पीछे छोड़े गए छोटे विचलन भी हैं। शुरुआती डीपफेक में, इन्हें अक्सर मानवीय आंखों से पकड़ा जा सकता है और खराब डीपफेक में अभी भी कुछ चेतावनी संकेत हो सकते हैं, जैसे किनारों के आसपास धुंधलापन, एक ओवरस्मूथेड चेहरा, डबल आइब्रो, ग्लिच, या आम तौर पर "अप्राकृतिक" महसूस होता है कि चेहरा कैसा है फिट बैठता है ।

अधिकांश भाग के लिए, हालांकि, तकनीकों में अब उस बिंदु तक सुधार हुआ है जहां ये कलाकृतियां केवल वीडियो डेटा के माध्यम से संयोजन करने और पिक्सेल स्तर पर चीजों की जांच करने वाले अन्य एल्गोरिदम के लिए दृश्यमान हैं। उनमें से कुछ बहुत रचनात्मक हो सकते हैं, जैसे एक तकनीक जो यह देखने के लिए जांच करती है कि नाक की दिशा चेहरे की दिशा से मेल खाती है या नहीं। मनुष्यों के लिए यह अंतर बहुत सूक्ष्म है, लेकिन मशीनें इस पर बहुत बढ़िया निकली हैं।

बायोमीट्रिक सुराग

थोड़ी देर के लिए ऐसा लग रहा था कि डीपफेक को अनमास्क करने की कुंजी "आंखों से बंद" स्रोत छवियों की सापेक्ष कमी के कारण प्राकृतिक ब्लिंकिंग पैटर्न की कमी थी। अगली पीढ़ी की डीपफेक तकनीक को बेहतर ब्लिंकिंग को शामिल करने में देर नहीं लगी, हालांकि, उस तकनीक की प्रभावशीलता को जल्दी से कम कर दिया।

अन्य बायोमेट्रिक संकेतक अभी तक पूरी तरह से क्रैक नहीं हुए हैं, हालांकि, अलग-अलग विचित्रताओं की तरह, जो एल्गोरिदम आसानी से एक डीपफेक में स्वचालित नहीं हो सकते क्योंकि उन्हें इस्तेमाल की जा रही भाषा की कुछ प्रासंगिक समझ की आवश्यकता होती है। छोटी-छोटी आदतें जैसे कि आश्चर्यचकित होने पर तेजी से झपकाना या प्रश्न पूछने पर भौंहें उठाना, एक डीपफेक द्वारा उठाया और इस्तेमाल किया जा सकता है, लेकिन जरूरी नहीं कि सही समय पर हो क्योंकि वे (अभी तक) स्वचालित रूप से यह पता नहीं लगा सकते हैं कि कब करना है उन आंदोलनों को तैनात करें।

वीडियो छवियों का उपयोग करके दिल की धड़कन को पढ़ने में सक्षम होने के कारण एआई में डीपफेक डिटेक्शन से परे बहुत सारे एप्लिकेशन हैं, लेकिन आवधिक आंदोलनों और रंग परिवर्तनों की तलाश में जो हृदय गति को संकेत देते हैं, एआई-जनित धोखेबाजों की पहचान करने में मदद कर सकते हैं। सबसे स्पष्ट सस्ता तब होता है जब एक डीपफेक में बिल्कुल भी दिल की धड़कन नहीं होती है, लेकिन डीपफेक में अक्सर दालें होती हैं। फिर भी, अनियमितताएं (जैसे चेहरे के अलग-अलग हिस्सों में अलग-अलग हृदय गति प्रदर्शित करना) अभी भी एक डीपफेक की पहचान करने में मदद कर सकती है।

AI प्रोजेक्ट

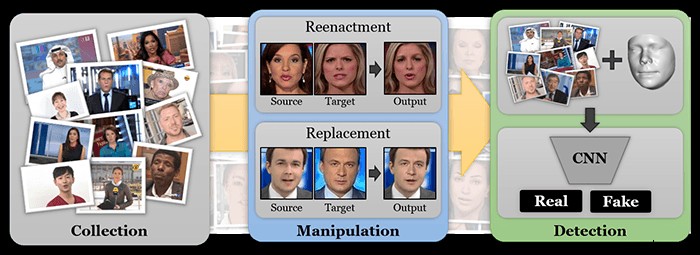

डीपफेक समस्या को सुलझाने में कई बड़े नाम बहुत रुचि रखते हैं। Facebook, Google, MIT, ऑक्सफ़ोर्ड, बर्कले, और कई अन्य स्टार्टअप और शोधकर्ता इस समस्या से निपटने के लिए कृत्रिम बुद्धिमत्ता का प्रशिक्षण दे रहे हैं ताकि ऊपर सूचीबद्ध विधियों का उपयोग करके नकली वीडियो का पता लगाया जा सके।

एक चीज जिस पर फेसबुक और गूगल दोनों काम कर रहे हैं, वह है काम करने वाले अभिनेताओं के उच्च-गुणवत्ता वाले वीडियो का एक डेटासेट बनाना, जिसका उपयोग वे फिर डीपफेक बनाने के लिए करते हैं। इन पर प्रशिक्षित एआई फिर यह पता लगा सकता है कि डीपफेक के गप्पी संकेत क्या हैं और उनका पता लगाने का काम सौंपा जा सकता है।

बेशक, यह केवल तब तक काम करता है जब तक शोधकर्ता सबसे अद्यतित तकनीक का उपयोग करके डीपफेक उत्पन्न करना जारी रखते हैं, जिसका अर्थ है कि खोजे जा रहे नवीनतम डीपफेक ट्रिक्स और इन एल्गोरिदम को पकड़ने में सक्षम होने के बीच हमेशा थोड़ा अंतराल होगा। किसी भी भाग्य के साथ, हालांकि, डीपफेक की पहचान करने के लिए वास्तविक चूहों का उपयोग करने वाले प्रयोग सामने आएंगे और हमें बढ़त देंगे।

प्रमाणीकरण

डिटेक्शन प्रौद्योगिकियां डीपफेक का पूरा जवाब नहीं हैं, हालांकि, उनके पास शायद कभी भी 100% सफलता दर नहीं होगी। डीपफेक जिनके पास कुछ समय और पैसा लगा है, वे शायद बहुत सारे सूंघने के परीक्षण और वर्तमान एआई विधियों को पास कर सकते हैं। और आइए याद रखें कि इंटरनेट कैसे काम करता है:भले ही ये नकली पकड़े गए हों, फिर भी उन्हें फिर से प्रसारित किया जाएगा और लोगों के कुछ सबसेट द्वारा विश्वास किया जाएगा।

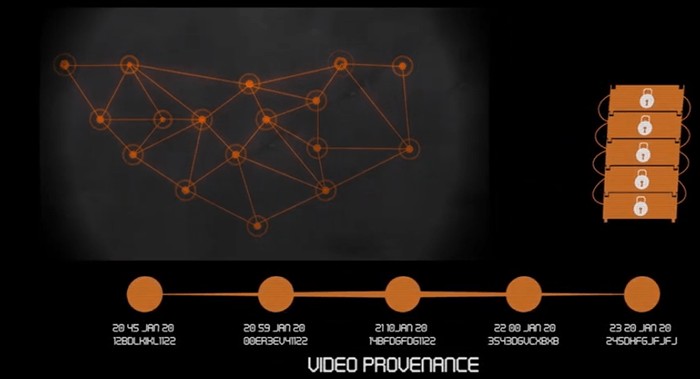

इसलिए किसी प्रकार के सत्यापन तंत्र का होना भी महत्वपूर्ण है - इस बात का कुछ प्रमाण कि कौन सा वीडियो मूल है या ऐसा कुछ जो इंगित कर सकता है कि क्या वीडियो को संशोधित किया गया है। फैक्टम, एम्बरवीडियो और एक्सिओम जैसी कंपनियां वीडियो के बारे में डेटा को अपरिवर्तनीय ब्लॉकचेन पर एन्कोड करके कर रही हैं।

इन परियोजनाओं में से कई के पीछे मूल विचार यह है कि एक वीडियो फ़ाइल में निहित डेटा या एक निश्चित कैमरे द्वारा उत्पन्न डेटा का उपयोग एक अद्वितीय हस्ताक्षर उत्पन्न करने के लिए किया जा सकता है जो वीडियो के साथ छेड़छाड़ करने पर बदल जाएगा। आखिरकार, सोशल मीडिया पर अपलोड किए गए वीडियो में ऑथेंटिकेशन कोड जेनरेट करने के विकल्प के साथ आ सकता है जिसे मूल अपलोडर यह साबित करने के लिए ब्लॉकचैन पर रजिस्टर कर सकता है कि वे असली वीडियो के मालिक हैं।

इन समाधानों में निश्चित रूप से समस्याओं का अपना सेट है, जैसे वीडियो एन्कोडिंग फ़ाइल में डेटा बदलना और वीडियो सामग्री को वास्तव में बदले बिना हस्ताक्षर बदलना, या वैध वीडियो संपादन हस्ताक्षर को गड़बड़ाना। हालांकि, उच्च-दांव स्थितियों में, जैसे कि वाणिज्यिक लेनदेन जहां छवियों का उपयोग डिलीवरी को सत्यापित करने या निवेशक सहायता प्राप्त करने के लिए किया जाता है, इस तरह की प्रमाणीकरण परत होने से डीपफेक-संबंधित धोखाधड़ी को रोकने में मदद मिल सकती है।

क्या डीपफेक फोटोशॉप से ज्यादा खतरनाक हैं?

इस बिंदु पर, हम सभी केवल यह मान लेते हैं कि छवियां वास्तविक नहीं हो सकती हैं क्योंकि हम पूरी तरह से जानते हैं कि एक स्थिर छवि में लगभग कुछ भी वास्तविक दिखने के लिए तकनीक मौजूद है। आखिरकार, हम वीडियो को उसी तरह के संदेह के साथ देखना शुरू कर सकते हैं क्योंकि उन्हें फ़ेक करना उतना ही आसान और आश्वस्त करने वाला हो जाता है जितना कि फ़ोटोशॉप वर्तमान में छवि संपादन करता है। हालांकि, सामान्य जागरूकता के बावजूद, वास्तविक जीवन की बहुत सारी घटनाओं की कल्पना करना आसान है, जो बहुत दूर के भविष्य में एक अच्छी तरह से समयबद्ध, उच्च-गुणवत्ता वाले डीपफेक के साथ शुरू हो रही हैं।