यह मार्गदर्शिका आपको चरण दर चरण सिखाएगी कि ओपन सोर्स (फ्री) सॉफ्टवेयर - wget का उपयोग करके लिनक्स, विंडोज या मैकओएस में कमांड लाइन से फाइल कैसे डाउनलोड करें। Wget Linux और UNIX परिवेशों के लिए एक बहुत अच्छा कमांड-लाइन डाउनलोडर है जिसे Windows और macOS में भी पोर्ट किया गया है। इस तथ्य से मूर्ख मत बनो कि यह एक कमांड लाइन उपकरण है। यह बहुत शक्तिशाली और बहुमुखी है और आज के आसपास के कुछ बेहतरीन ग्राफिकल डाउनलोडर से मेल खा सकता है। इसमें डाउनलोड को फिर से शुरू करने, बैंडविड्थ नियंत्रण, यह प्रमाणीकरण को संभाल सकता है, और बहुत कुछ जैसी विशेषताएं हैं। मैं आपको wget का उपयोग करने की मूल बातें बताऊंगा और फिर मैं आपको दिखाऊंगा कि कैसे आप wget का उपयोग करके अपनी वेबसाइट का पूर्ण बैकअप स्वचालित कर सकते हैं और क्रॉन .

आइए wget इंस्टॉल करके शुरू करें। अधिकांश लिनक्स वितरण पहले से स्थापित wget के साथ आते हैं। यदि आप wget की एक प्रति के बिना अपने आप को एक Linux मशीन लैंड करने का प्रबंधन करते हैं, तो निम्न का प्रयास करें। Red Hat Linux आधारित सिस्टम पर ऐसे Fedora का आप उपयोग कर सकते हैं:

# यम इंस्टॉल wget

या यदि आप उबंटू जैसे डेबियन आधारित सिस्टम का उपयोग करते हैं:

# sudo apt-get install wget

उपरोक्त में से एक को आपके लिए चाल चलनी चाहिए। अन्यथा, पैकेज प्राप्त करने और स्थापित करने का तरीका देखने के लिए अपने लिनक्स वितरण के मैनुअल की जांच करें। विंडोज़ पर उपयोगकर्ता इस वेबसाइट के माध्यम से wget तक पहुंच सकते हैं, और मैक उपयोगकर्ताओं के लिए हमारे पास मैकोज़ में wget कैसे स्थापित करें, इस बारे में एक पूर्ण मार्गदर्शिका है।

एक डाउनलोड प्रबंधक को सबसे बुनियादी ऑपरेशन एक यूआरएल से एक फाइल डाउनलोड करना है। यहां बताया गया है कि आप फ़ाइल डाउनलोड करने के लिए wget का उपयोग कैसे करेंगे:

# wget https://www.simplehelp.net/images/file.zip

हाँ, यह इतना आसान है। अब कुछ और मजेदार करते हैं। आइए एक पूरी वेबसाइट डाउनलोड करें। यहाँ wget की शक्ति का स्वाद है। यदि आप एक वेबसाइट डाउनलोड करना चाहते हैं, तो आप उस गहराई को निर्दिष्ट कर सकते हैं जिससे wget को फ़ाइलें प्राप्त करनी चाहिए। मान लें कि आप Yahoo! के होम पेज के पहले स्तर के लिंक डाउनलोड करना चाहते हैं। यहां बताया गया है कि यह कैसे करेगा:

# wget -r -l 1 https://www.yahoo.com/

यहां प्रत्येक विकल्प क्या करता है। -r फ़ाइलों की पुनरावर्ती पुनर्प्राप्ति को सक्रिय करता है। -l स्तर के लिए खड़ा है, और संख्या 1 इसके आगे यह बताता है कि फाइलें लाते समय कितने स्तरों तक जाना है। स्तरों की संख्या बढ़ाकर दो करने का प्रयास करें और देखें कि wget में कितना समय लगता है।

अब यदि आप किसी वेबसाइट से सभी "जेपीईजी" छवियों को डाउनलोड करना चाहते हैं, तो लिनक्स कमांड लाइन से परिचित उपयोगकर्ता अनुमान लगा सकता है कि "wget http://www.sevenacross.com*.jpeg" जैसा कमांड काम करेगा। खैर, दुर्भाग्य से, ऐसा नहीं होगा। आपको जो करना है वह कुछ इस प्रकार है:

# wget -r -l1 –no-parent -A.jpeg https://www.yahoo.com

wget में एक और बहुत उपयोगी विकल्प डाउनलोड को फिर से शुरू करना है। मान लें कि आपने एक बड़ी फ़ाइल डाउनलोड करना शुरू कर दिया है और डाउनलोड पूरा होने से पहले आपने अपना इंटरनेट कनेक्शन खो दिया है। आप -c . का उपयोग कर सकते हैं अपने डाउनलोड को वहीं से जारी रखने का विकल्प जहां से आपने इसे छोड़ा था।

# wget -c http://www.example_url.com/ubuntu-live.iso

अब एक वेबसाइट का दैनिक बैकअप सेट करने के लिए आगे बढ़ते हैं। निम्न आदेश आपकी स्थानीय डिस्क में एक साइट का दर्पण बनाएगा। इस उद्देश्य के लिए wget के पास एक विशिष्ट विकल्प है, –मिरर . अपनी वेबसाइट के पते के साथ सेवनक्रॉस.कॉम को प्रतिस्थापित करते हुए, निम्न आदेश का प्रयास करें।

# wget –mirror http://www.sevenacross.com/

जब आदेश चल रहा हो तो आपके पास अपनी वेबसाइट का स्थानीय दर्पण होना चाहिए। यह बैकअप के लिए एक बहुत ही उपयोगी उपकरण बनाता है। आइए इस कमांड को एक कूल शेल स्क्रिप्ट में बदल दें और इसे हर रात आधी रात को चलाने के लिए शेड्यूल करें। अपना पसंदीदा टेक्स्ट एडिटर खोलें और निम्नलिखित टाइप करें। बैकअप के पथ और वेबसाइट URL को अपनी आवश्यकताओं के अनुकूल बनाना याद रखें।

<ब्लॉकक्वॉट>#!/बिन/बैश

YEAR=`दिनांक +”%Y”`

MONTH=`तारीख +”%m”`

DAY=`तारीख +”%d”`

BACKUP_PATH=`/home/backup/` # पथ को अपनी बैकअप निर्देशिका से बदलें

WEBSITE_URL=`http://www.sevenacross.net` # url को उस वेबसाइट के पते से बदलें जिसका आप बैकअप लेना चाहते हैं

# बैकअप निर्देशिका बनाएं और उसमें ले जाएं

cd $BACKUP_PARENT_DIR/$YEAR/$MONTH

mkdir $DAY

cd $DAY

wget – मिरर ${WEBSITE_URL}

अब इस फाइल को कुछ इस तरह से सेव करें जैसे website_backup.sh और इसे निष्पादन योग्य अनुमतियां प्रदान करें:

# chmod +x website_backup.sh

crontab . के साथ अपना क्रॉन कॉन्फ़िगरेशन खोलें आदेश दें और अंत में निम्न पंक्ति जोड़ें:

0 0 * * * /path/to/website_backup.sh

आपके पास /home/backup/YEAR/MONTH/DAY में अपनी वेबसाइट की एक प्रति होनी चाहिए हर दिन। क्रॉन और क्रोंटैब का उपयोग करने में अधिक सहायता के लिए, यह ट्यूटोरियल देखें।

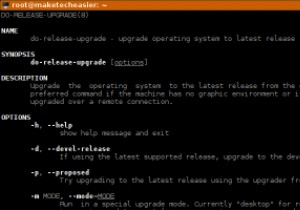

अब जब आपको कमांड लाइन से फ़ाइलें डाउनलोड करने की मूल बातें मिल गई हैं, तो आप wget के मैन पेज को पढ़कर उन्नत सामग्री में प्रवेश कर सकते हैं - बस man wget टाइप करें कमांड लाइन से।